Jaką kartę graficzną wybrać?

Większość osób myśli o kartach graficznych w kontekście gier komputerowych. Jest to zrozumiałe, gdyż zwykle właśnie tam przeciętny użytkownik w pełni wykorzystuje ich możliwości. Jednak gry to niejedyny obszar zastosowań komputera, który wymaga wydajnych układów graficznych. Obróbka grafiki, renderowanie oraz modelowanie animacji 3D, a także skomplikowane obliczenia naukowe, to kolejne zastosowania wymagające bardzo wydajnych GPU.

Początkowo układy odpowiedzialne za wyświetlanie grafiki były bardzo ubogie w możliwości. Pierwsze z nich umożliwiały tylko i wyłącznie pokazywanie znaków tekstowych ( tryb tekstowy). Kolejne modele dawały możliwość obsługi kolorów, co sprowadza się do manipulacji kolorami poszczególnych pikseli ( tryb graficzny).

Spis treści

Producenci

Nvidia

Spółkę założono w 1993 roku w Stanach Zjednoczonych. Firma zajmuje się produkcją układów scalonych, jednak najbardziej znana jest ze swoich układów graficznych (większość udziału w rynku). Flagowym produktem tej firmy są układy z serii GeForce.

Nazewnictwo modeli GeForce

Druga cyfra w nazwie układu odnosi się do jego wydajności:

- x1x, x2x, x3x, x4x oraz x5x: modele budżetowe, np. GeForce GT 630

- x6x oraz x7x: układy średnio wydajne, dedykowane na rynek masowy, np. GeForce GTX 760

- x8x i x9x: jednostki o najwyższej wydajności, np. GeForce GTX 790

ATI/AMD

ATI Technologies Inc. to czołowy producent kart graficznych na świecie, chociaż w ich ofercie znajdowały się także chipsety do płyt głównych oraz inne układy scalone . Firma powstała w 1985 roku i ma swoją siedzibę w Markham oraz w Ontario (Kanada). W 2006 ATI połączyło się z AMD (jeden z największych producentów procesorów na rynku). Procesory graficzne (GPU) produkowane przez ATI/AMD naszą nazwę Radeon.

AMD Fusion

W 2011 roku AMD wyznaczył nowy trend na rynku kart graficznych. Otóż inżynierowie połączyli (zintegrowali) GPU bezpośrednio z procesorem. Tak powstałe układy firma nazwała APU. W ich ślady poszedł również Intel, ale o tym poniżej.

Intel

Amerykańska spółka powstała w 1968 roku. Intel to największy na świecie producent układów scalonych, który znany jest przede wszystkim z produkcji procesorów. Jednak od 2010 w większości swoich procesorów Intel montuje zintegrowane układy graficzne z serii: Intel HD Graphics, Intel Iris Graphics, Intel Iris Pro Graphics.

Procesor graficzny (GPU)

To podstawowy element każdej karty graficznej. W dużej mierze to właśnie on decyduje o potencjalnych możliwościach całego układu. Jego najważniejszym zadaniem jest dokonywanie skomplikowanych obliczeń mających na celu wygenerowanie grafiki – jak się okaże poniżej od niedawna ma on też inne zastosowania.

Taktowanie procesora graficznego

O możliwościach GPU mówi nam przede wszystkim jego szybkość taktowania wyrażana w Hercach – w praktyce częstotliwości zegara są tak duże, że stosujemy odpowiednie przedrostki np. MHz (milion Herców), GHz (miliard Herców). Im taktowanie będzie wyższe, tym procesor graficzny będzie w stanie efektywniej przetwarzać dane, a tym samym grafika będzie generowana szybciej. Jednak parametr ten może służyć nam do porównywania kart tylko z tym samym GPU. W innym przypadku wyniki będą niemiarodajne.

Obciążenie GPU oraz wydajność

Z pewnością grałeś już w gry wideo i wiesz, że "obraz obrazowi nierówny". W zależności od rozdzielczości generowanych scen, która wpływa na ilość szczegółów oraz od innych dodatkowych parametrów (HDR, cieniowanie, przezroczystość), procesor graficzny jest obciążany w różnym stopniu. O wydajności bardzo dużo powiedzą nam różnego rodzaju benchmarki (programy do testowania wydajności), np. 3dmark 11. Kolejny sposób to sprawdzenie jak szybko karta generuje poszczególne klatki w grach.

Jak sprawdzić ilość klatek?

Większość osób kupuje kartę graficzną z myślą o grach. Komfortowe granie możliwe jest wtedy, gdy karta wyświetli w ciągu sekundy nie mniej niż 25 klatek. Jedną z popularniejszych aplikacji, która umożliwia sprawdzenie tego parametru jest Fraps , który możemy pozyskać na licencji Shareware. Dodatkowo w Internecie jest wiele gotowych testów, które pokazują jak konkretne modele karty spisują się z danymi grami (maksymalna, minimalna oraz średnia ilość klatek / sekundę).

Ilość klatek w grze Post Apocalyptic Mayhem zmierzona programem Fraps

Jeden GPU różni producenci

Produkcja kart przebiega w dosyć specyficzny sposób. Firmy NVIDIA oraz ATI wytwarzają „jedynie” procesory graficzne oraz obwody drukowane (płytka PCB). Natomiast pozostałe komponenty oraz ich parametry pozostają w gestii zewnętrznych firm, np. Asus, Gainward, Gigabyte, Palit. Dlatego na rynku spotkamy układy z tym samym procesorem graficznym, np. GTX780, które będą się różnić taktowaniem GPU, taktowaniem pamięci oraz jej pojemnością, a także zastosowanym chłodzeniem – różnice te nie są jednak duże, bo każdy producent spotka się z tymi samymi ograniczeniami narzuconymi przez ten samy GPU. Przykład poniżej dla GTX780:

| Model | Taktowanie GPU | Taktowanie pamięci | Pojemność pamięci | Chłodzenie |

|---|---|---|---|---|

| Asus STRIX-GTX780-OC-6GD5 | 889 MHz | 6008 MHz | 6144 MB | aktywne |

| Gigabyte GV-N780OC-3GD | 900 MHz | 6008 MHz | 3072 MB | aktywne |

| Palit NE5X780T10FBJ | 1033 MHz | 6200 MHz | 3072 MB | aktywne |

Czym są shadery?

Podstawową metodą w grafice 3D, mającą na celu pokazanie możliwie realistycznych scen jest teksturowanie. Proces ten polega na nakładaniu na trójwymiarowe obiekty tekstur (obrazy bitmapowe). Jednak oddawany w ten sposób realizm na swoje ograniczenia. Dlatego też, aby generowany obraz był jeszcze bardziej realistyczny opracowano tak zwane shadery (cienie).

Shaderami nazywamy niewielkie programy komputerowe, które mają za zadanie określać właściwości wierzchołków oraz pikseli. Układy graficzne z shaderami, to po prostu karty graficzne sprzętowo wspierające obsługę shaderów.

Cieniowanie umożliwia zdecydowanie bardziej zaawansowane modelowanie materiału oraz oświetlenie obiektu niż to ma miejsce w zwykłym teksturowaniu. Jednym z pierwszych desktopowych układów graficznych ze wsparciem dla shaderów był GeForce 3, który został wypuszczony na rynek na początku 2001.

Efekty dzięki cieniowaniu

Oświetlenie HDR

Technika pozwalająca na rendering świata z bardzo realistycznym oświetleniem przy wykorzystaniu szerszej jasności oświetlenia, niż ma to miejsce normalnie. Przykładem może być efekt oślepiania podczas patrzenia na Słońce.

Efekt HDR w grze Half-Life 2: Lost Coast

Źródło www.pl.wikipedia.com

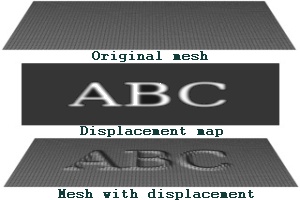

Mapa przemieszczeń

Teksturę nakłada się na siatkę wielokątów, a teksele (najmniejsze punkty tekstury) wyznaczają odległość na jaką wierzchołki siatki mają być przemieszczone.

Mapa przemieszczeń

Źródło www.en.wikipedia.com

Refrakcja

Shadery umożliwiają tutaj bardzo realistyczne pokazanie refrakcji (zjawisko załamania fali, kiedy przechodzi ona przez dwa ośrodki, np. powietrze – woda).

Zaszumienie obrazu, jego rozmycie, zmiana kolorów

Ponadto, przy wykorzystaniu technologii cieniowania sprzętowego, możliwe są do uzyskania takie efekty jak: zmiana kolorów poszczególnych pikseli, rozmycie obrazu czy także jego zaszumienie.

Rodzaje cieniowania

- Pixel Shader (cieniowanie pikseli)

- Vertex Shader (cieniowanie wierzchołkowe)

- Geometry Shader (cieniowanie geometryczne)

- Stream Processors / Unified shader (pełnią funkcję zarówno cieniowania pikseli jak i cieniowania wierzchołków)

Cieniowanie pikseli (Pixel Shader)

Jednostka ta ma za zadanie wyliczanie kolorów poszczególnych pikseli. W jaki sposób to robi? Dzięki sterowaniu kolorem pikseli za pomocą specjalnie do tego celu napisanych programów (shaderów). Na chwilę obecną większość zaawansowanych efektów graficznych może być wykonana właśnie dzięki tym niewielkim programom przypisanym do konkretnego piksela.

Wersje cieniowania pikseli

Od początku powstania pierwszego, sprzętowo wspieranego cieniowania pikseli upłynęło już kilkanaście lat. Od tego momentu powstało już kilka, a dokładniej 5 wersji Pixel Shader. Obecnie najnowsza z nich, to wersja 5.0, którą wspiera biblioteka DirectX 11 oraz OpenGL 4.1.

Cieniowanie wierzchołkowe

Ten rodzaj cieniowania odpowiada za przetwarzanie wierzchołków wielokątów. Dokładniej chodzi tutaj o transformowanie położenia takiego wierzchołka z przestrzeni 3D do współrzędnych w przestrzeni 2D. Vertex Shader operuje na takich atrybutach wierzchołka jak: współrzędne tekstur, kolory oraz położenie. Cieniowanie wierzchołkowe nie daje jednak możliwości tworzenia nowych wierzchołków. Zakończenie etapu cieniowania wierzchołkowego jest początkiem dla kolejnego procesou, tj. albo cieniowania geometrycznego, albo rasteryzacji.

Wersje cieniowania wierzchołków

Tutaj podobnie jak w przypadku cieniowania pikseli mamy do czynienia z 5 generacjami Vertex Shader. Ostatnia z nich, to 5.0. Wersję tą wspierają DirectX 11 oraz OpenGL 4.1.

Cieniowanie geometryczne

Z tą technologią karty graficzne, a dokładniej ich GPU, potrafią usuwać bądź dodawać wierzchołki do siatki wierzchołków. Konkretniej, cieniowanie wierzchołków wykorzystywane jest do tworzenia proceduralnego obiektów geometrycznych, a także do powiększania objętościowych detali w przypadku istniejącej już siatki wierzchołków. Wsparcie dla tej technologii rozpoczęło się od wersji 10 DirectX oraz od wersji 3.1 biblioteki OpenGL.

Stream Processors / Unified shader

Od momentu wydania biblioteki DirectX w wersji 10 zniknął podział na cieniowanie pikseli oraz oraz cieniowanie wierzchołkowe. Obecnie GPU wyposaża się w jednolite jednostki, które w zależności od potrzeb wykonują obliczenia związane z cieniowaniem wierzchołkowym lub cieniowaniem pikseli. nVidia jednostki te nazywa Unified Shaders, a ATI/AMD zwie je Stream Processors.

Inne technologie

Współczesne karty graficzne wspierają wiele technologii, które zwiększają realizm generowanej grafiki:

- PhysX - technologia pozwalająca na dokładne odwzorowanie zachowań obiektów na wzór świata fizycznego. Umożliwia określenie skutków oddziaływań pomiędzy obiektami poprzez wcześniejsze zdefiniowanie ich prędkości, masy oraz przyspieszenia. Technologia ta bierze pod uwagę również np. grawitację

- GPGPU - umożliwia wykorzystanie kart graficznych w zupełnie nowym obszarze. Otóż dzięki GPGPU układ graficzny może być wykorzystywany do przeprowadzania skomplikowanych obliczeń (przede wszystkim równoległych). Co ciekawe wiele obecnie produkowanych superkomputerów działa w oparciu o GPU obsługujące GPGPU.

- Full Scene Anti-Aliasing - technologia pozwalająca na wygładzenie krawędzi (pozbywanie się charakterystycznych schodków)

Porównanie - bez antyaliasingu oraz z antyaliasingiem

- Efekty cząsteczkowe - umożliwiają odwzorowanie takich zjawisk, jak np.: deszcz, śnieg, pył oraz dym

- Filtrowanie anizotropowe - poprawia jakość obiektów znajdujących się w znacznej odległości od obserwatora (kamery) – zwłaszcza tych umieszczonych pod niewielkimi kątami

Karta dedykowana czy zintegrowana?

Grafika zintegrowana to ta na stałe związana z płytą główną (coraz rzadsze rozwiązanie) lub procesorem - większość procesorów na rynku wyposażonych jest w takie rozwiązanie.

Z kolei grafika dedykowana jest oferowano w postaci zewnętrznego modułu, który wpinamy w specjalne gniazdo na płycie głównej (PCI Express). W razie konieczności taką kartę możemy wymienić na inną – trzeba jednak wziąć pod uwagę kilka dodatkowych czynników, takich jak: wersja złącza PCI-E, moc zasilacza oraz wydajność pozostałych podzespołów, a zwłaszcza procesora.

Różnica nie sprowadza się tutaj bynajmniej tylko do rodzaju połączenia (na stała lub modułowe), ale również, a może przede wszystkim, do wydajności. Karty dedykowany dysponują zwykle zdecydowanie większą mocą obliczeniową, dlatego przystosowane są do uruchamiania gier komputerowych, przetwarzania animacji 3D lub renderingu. Natomiast grafika dedykowana z racji mniejszej wydajności nie poradzi sobie z takimi zastosowaniami. Jednak znakomicie sprawdzi się w typowo domowych zastosowaniach – Internet, filmy HD, programy biurowe, obróbka grafiki 2D oraz proste gry.

Pamięć wideo

Przechowuje szeroko pojęte dane na temat obrabianego obrazu.

Pojemność pamięci

Pojemność pamięci jest istotna, ale niektórzy przeceniają ten parametr. Jej duża ilość wymagana jest w sytuacji, gdy będziemy przetwarzać grafikę w w dużych rozdzielczościach (gry, obróbka grafiki, renderowanie).

Rodzaj pamięci

Obecnie w kartach graficznych wykorzystujemy 5 rodzajów pamięci. Jednak tak naprawdę, to obecnie w grę wchodzą układy tylko z pamięcią GDDR. Z rodzajem pamięci łączą się takie parametry jak szybkość taktowania oraz przepustowość. Im te parametry będą wyższe tym lepiej.

| Typ pamięci | Częstotliwość taktowania (MHz) | Przepustowość pamięci (GB/s) |

|---|---|---|

| DDR | od 200 do 400 | od 1.6 do 3.2 |

| DDR2 | od 400 do 1066 | od 3.2 do 8.5 |

| DDR3 | od 700 do 2000 | od 6.4 do 12.8 |

| GDDR4 | od 1600 do 3200 | od 12.8 do 25.6 |

| GDDR5 | od 3500 do ? | od 28 do ? |

Szyna pamięci

Szerokość szyny pamięci jest istotna i wpływa bezpośrednio na szybkość przesyłania danych w układzie graficznym. Szerokość szyny pamięci wyrażamy w bitach. Obecnie minimum to 256 bitów. Najwydajniejsze układy posiadają szynę nawet 512 bitową.

Kilka kart w jednym komputerze

Czy możliwe jest umieszczenie w komputerze nie jednaj, a kilku kart? Okazuje się, że tak. NVIDIA technologię tą nazywa SLI, natomiast AMD/ATI zwie ją CrossFire (CrossFireX).

W zależności od wersji SLI (CrossFire) możemy połączyć 2, 3 lub 4 karty graficzne. Musimy jednak dysponować odpowiednią płytą główną.

Wbrew pozorom rozwiązanie to jest dosyć stare, bo zaprezentowano je już w 1998 roku (połączono dwie karty Voodoo 2). Mimo tego pomysł ten zniknął na kilka lat, by pojawić się znowu w 2004 roku pod nazwą 2-Way SLI.

Współpraca kilku układów graficznych oznacza bardzo duży przyrost wydajności.

Rodzaje chłodzenia

Karta graficzna, to bardzo skomplikowane układy wytwarzające dużo ciepła podczas swojej pracy - głównie chodzi tutaj o sam procesor (GPU) oraz pamięć. Dlatego niezwykle ważne jest odpowiednie chłodzenie układu, zwłaszcza gdy w przyszłości myślimy o przetaktowaniu karty graficznej (zwiększenie częstotliwości zegara GPU lub/i pamięci).

Aktywne

Ostatnio w dużej mierze mamy do czynienia z chłodzeniem aktywny. Działa ono w ten sposób, iż bezpośrednio na GPU montuje się radiator, a na nim wentylator. GPU oddaje część ciepła radiatorowi, ten ogrzewa powietrze znajdujące wokół niego, a wentylator "wysysa" to powietrze na zewnątrz. Tak więc w przypadku chłodzenia aktywnego występuje zarówno radiator jak i wentylator. Plus tej metody, to duża wydajność chłodzenia. Minusem natomiast możliwa głośna praca takiego układu.

Pasywne

W chłodzeniu pasywnym mamy do czynienia z samym radiatorem, który przejmuje część ciepła z GPU, a dzięki stosunkowo dużej powierzchni oddaje go do otoczenie. Między procesorem, a radiatorem zwykle znajduje się tzw. pasta termoprzewodząca, która ułatwia oprowadzanie ciepła z procesora. Rozwiązanie to nie powoduje wydzielania hałasu. Minus natomiast, to mała efektywność. Ten typ chłodzenia sprawdzał się w układach o obniżonym taktowaniu.

Chłodzenie wodą

Spotykanym również rozwiązaniem jest chłodzenie za pomocą wody. Rozwiązanie to jest bardzo wydajne, a ponadto nie wydziela żadnego hałasu (czasami niewielkie syczenie pompy). Do chłodzenia wodą zwykle stosujemy następujące elementy: zbiornik wyrównawczy (rezerwuar), blok wodny (zwykle miedziany lub aluminiowy, który montujemy na samym procesorze graficznym i doprowadzamy dwa węże - jeden odprowadzający, a drugi doprowadzający wodę), chłodnicę oraz pompę. Ten typ chłodzenia jest najdroższym, ale najbardziej efektywnym wariantem - stosuje się go praktycznie tylko w przypadku stosowania overclockingu (przetaktowania).

Moc zasilacza

Współczesne karty graficzne, to obok procesorów podzespoły komputera pobierające najwięcej mocy. Dlatego szczególnie istotnym jest dobór zasilacza, który będzie w stanie wytworzyć odpowiednią ilość mocy. W specyfikacjach karty zwykle podaje się jej zapotrzebowanie na moc.

Rodzaje złącz

Obecnie każde desktopowe układy graficzne wyposaża się w wiele rodzajów złącz, które umożliwiają komunikację z różnymi urządzeniami – poza monitorami mogą to być telewizory, kamery, projektory itd.

| Złącze | Uwagi | Zdjęcie | ||

|---|---|---|---|---|

| DVI | ||||

| DVI-I Przysyłany jest tym łączem zarówno sygnał cyfrowy, jak i również analogowy. Dlatego oprócz monitorów, które przetwarzają sygnał cyfrowy (LCD), możemy podłączyć również monitor analogowy (trzeba tylko zastosować specjalną przejściówkę na złącze D-Sub). |  | |||

| DVI-D Złączem tym mamy możliwość przesłania tylko i wyłączenie sygnały cyfrowego, a więc podłączymy za jego pomocą tylko monitor przetwarzający sygnał cyfrowo (LCD). Czasami tym złączem możemy przesłać również dźwięk, jednak jest to niezgodne ze standardem (wykorzystamy wtedy wolne piny). |  | |||

| DVI-A Ten rodzaj złącza daje możliwość przesłania tylko sygnału analogowego. Podłączymy więc do niego np. monitor kineskopowy. |  | |||

| D-Sub (DE-15F) | Wykorzystywane jest do łączenia karty z monitorem analogowym (CRT). Również wykorzystywane do łączenia starszych paneli LCD | -grafa.png) | ||

| S-Video | Za pomocą tego złącza możemy podłączyć telewizor do naszego komputera. Przesyła ono odseparowany sygnał luminancji (jasność) oraz chrominancji (kolory). Zwykle występuje jako wtyczka typu mini-DIN z czterema pinami, ale spotykane są również 7 pinowe wtyczki S-Video. Często złącze opisane jest jako TV Out |  | ||

| VIVO | Gniazdo to montuje się w niektórych kartach graficznych. Przy wykorzystaniu tego złącza możliwe jest przesyłanie sygnału wizji zarówno z komputera jak i do komputera. Zwykle spotykamy je w postaci 9 pinowego gniazda miniDIN, do którego dołączono rozgałęźnik. Ten interfejs znajdziemy w kartach z "górnej półki". Zwykle obsługuje takie standardy jak: S-Video, komponentowe oraz kompozytowe - na wyjściu. Natomiast na wejściu mamy do czynienia zwykle ze standardami: S-Video oraz kompozytowym. Obsługa obrazu wideo na wejściu wymaga specjalnego oprogramowania. Podstawowymi zastosowaniami dla tego łącza są:

|  | ||

| Composite (RCA) | Popularnie zwane jest cinchami. Przesyłany jest nim tzw. sygnał zespolony. Umożliwia podłączenie telewizora (sygnał jest analogowy). Standard powoli wypierany |  | ||

| Gniazdo zasilania typu Molex | Stosowane w kartach z interfejsem AGP (praktycznie wyszedł z użycia – spotykany w starych kartach). |  |

Opinie o produktach

Oczywiście minusem PC są.. twórcy gier. Gdyby tylko optymalizacja była bardzo dobra to tak naprawdę nie trzeba by było kupować coraz lepszych kart graficznych. No ale przecież NVIDIA i AMD muszą z czegoś żyć :) To samo tyczy się programów. Adobe premiere pro CS 6 renderuje mi dany film np 6 minut a ten sam filmik program CYBERLINK POWER DIRECTOR renderuje mi 2 minuty, oczywiście ta sama rozdzielczość i format.

http://www.wykop.pl/link/1210233/nowa-era-grafiki-komputerowej-jakosc-fotograficzna-w-czasie-rzeczywistym/

I nie dajcie sobie wmówić w sklepie, że tylko super wypasiony zestaw poradzi sobie z dzisiejszymi aplikacjami. Obecnie dostępne zestawy z niższej półki doskonale dadzą sobie radę z Internetem, aplikacjami biurowymi, czy filmami.